@123 什么设备

-

小智AI聊天机器人esp32-s3-n8r2主控固件下载和编译设置发布在 技术交流

QQ技术交流群:538646196

一、 固件下载链接:

n8r2-v1.4.6_bread-compact-wifi.bin 【对应0.91寸oled屏面包板新版接线v2-wifi版本】

n8r2-v1.4.6_bread-compact-wifi-128x64.bin 【对应0.96寸oled屏面包板新版接线v2-wifi版本】

n8r2-v1.4.6_bread-compact-ml307.bin 【对应0.91寸oled屏面包板新版接线v2-AT版本】

n8r2- v1.4.6_bread-compact-ml307-128x64.bin 【对应0.96寸oled屏面包板新版接线v2-AT版本【

二、 源码编译设置

2.1 替换成8M的partitions.csv表格

2.2 flash size设置成8M

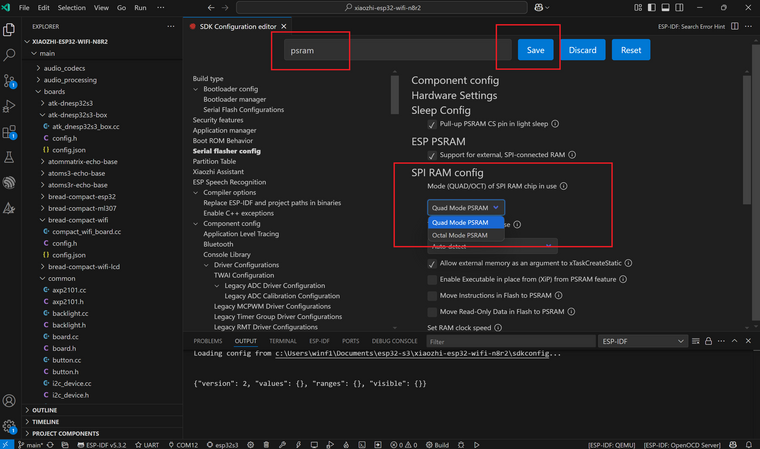

2.3 PSRAM模式设置成 quad mode

2.4 保存后重新编译即可

-

lio_sam和ndt导航精度差别的原因发布在 激光雷达

实际跑bag时发现,同样的地图同样的数据,参数调整好之后ndt导航的精度要比lio_sam的高。在机器人静止时,lio_sam大概有最大2厘米左右的定位波动。但是ndt可以做到2个毫米的定位波动。误差来自于雷达匹配误差上。

由于lio_sam是scan 到 map的匹配,而map本身可能存在误差,地图的真实点在地图点云上表现可能是一个点云分布。lio_sam匹配时按照最近点去找很有可能找到不是真实值。由于寻找匹配的随机性这样就定位就存在波动。比如实际是一个平整的墙面,但是建图后的点云很可能是有一定厚度的点云分布,这样匹配就存在这个厚度的误差。

ndt就不存在这个问题,它按照最大概率去匹配。很好的去掉了这个误差带来的随机影响。

-

raid 更换硬盘后 Ubuntu系统无法进入的解决方法发布在 技术交流

服务器是Ubuntu系统,安装在Intel的raid 10上。最近一个硬盘有坏道,尝试更换硬盘。首先在Ubuntu中下线有坏道的硬盘。然后关机安装上硬盘后显示如下画面

然后重启之后再也无法进入系统。尝试吧老硬盘换上去仍然没有效果。显示老硬盘状态为offline。

再次插入新硬盘状态变成degraded。经过各种搜索尝试最终找到原因。主板自带的raid 10 不是完整raid。其必须要在操作系统的协助下才能完成raid的功能。正常情况下如果服务器系统是windows,那么应该可以直接启动进入系统开始raid rebuild。板载的raid是intel的rst,但是这个功能不支持Linux。详细的可以参考 https://zhuanlan.zhihu.com/p/106623640。

我们采用的方法是在一块独立的硬盘上安装一个Windows Server 2016,然后装上对应版本的intel rst,注意版本一定要对应,可以根据主板信息到主板官网上去找。硬盘装上新盘。如果一切正常打开intel rst程序就能看到raid在rebuild。rst默认安装位置在

C:\Program Files (x86)\Intel\Intel(R) Rapid Storage Technology enterprise\IAStorUI.exe。

如此等待重建完成就可以了。

-

二维码摄像头和里程计的时间戳同步发布在 技术交流

假设里程计时间戳和二维码摄像头的时间戳都是准确的(或者和真实时间都差了一个相同的固定值),那么同一时刻通过里程计计算的机器人移动的相对位姿应该和通过二维码计算的相对位资完全一样。因为两个传感器数据同一时刻对应的是同一个机器人位置。

对于时间戳其真实值实际上对我们没有多大意义,更有意义的是不同传感器之间时间戳的偏差。通过这种方式我们可以用来校准这两个传感器的时间戳。我们可以以一个传感器的时间戳作为基准,其他传感器的时间戳对其到这个时间戳上。里程计时间戳就是一个很好的基准。

我们控制机器人下方扫码摄像头在机器人正中央,保证机器人在原地旋转时二维码始终在自己的摄像头范围中央。同时录制摄像头和里程计数据。通过里程计数据可以计算出一个相对于初始位置的相对位姿,通过二维码数据也可以计算出一个相对位姿。机器人以固定速度原地旋转。很容易计算出这两个位姿的差就是 delta_theta = delta_t * w, 其中delta_t就是两个传感器的时间戳差别,w是机器人旋转的角速度。如果时间戳的差距是固定的,那么就应该有这个角度差也是固定的。

通过实验我计算出 角度差均值是 -0.09949351795361913, 标准差是 0.014604546858801595

可以看到这两个传感器的时间戳基本上确实是一个定值。机器人角速度为2rad/s,则计算出时间戳大概差50ms。把这个偏差加入到计算中相关精度有了明显的提升。 -

RE: 雷达数据的运动校准和里程计时间同步发布在 激光雷达

@weijiz 还有一点,如果不进行运动校准,直接在odom坐标系下看scan数据,你会发现之前存在的运动校准误差消失了。这是因为rviz在odom下显示scan数据的时候不是按照整体显示的,它会计算每个点的时间戳去显示。相当于完成了运动校准。所以如果你的运动校准计算正确,那么你的计算数据在odom下就应该和rviz的原始数据重合。

-

雷达数据的运动校准和里程计时间同步发布在 激光雷达

雷达固定在机器人上,当机器人运动时由于LaserScan每个beam存在时间差就会产生运动误差。同时如果里程计和雷达本身存在时间差,也会造成扫描误差。不过这两个误差的表现形式有所区别。

首先是雷达的运动误差。如果在rviz中laser坐标系下看雷达数据。当机器人在原地快速旋转时,会发现雷达的x轴左右两边的数据是明显不一致的。如下图所示

右前方基本是两条平行线,当这个部分运动到雷达正前方时会发生形变

两条直线不再平行。这是由于x轴两边的数据正好对应差了一个scan time。雷达产生的相对移动是最大的。

通过计算实际时间差可以把这个修正回来。

图中红色就是修正后的数据。另一个主要的误差来自odom和scan的时间戳不同步。它会造成的误差表现是如果机器人在原地匀速旋转那么雷达数据和里程计当前对应的雷达数据就会差一个固定角度。如下图所示。

其中绿色是真值红色是测量值。同时这个角度也很容易算出是delta_t * w, 其中delta_t是时间戳差值,w是旋转角速度。

所以我们很容易通过现象去判断是否存在此误差。如果机器人原地旋转时在rviz中,odom坐标系下,你发现雷达数据随着角速度的不同有明显的整体的角度变化。那就说明存在一个雷达和里程计的时间戳是不同步的,有可能某个传感器的时间戳不准。

-

RE: rk3588在ros中使用ros_rknn_yolo包发布在 技术交流

@natsuki 在 rk3588在ros中使用ros_rknn_yolo包 中说:

ros_rknn_yolo文件夹内有没有正确创建venv子文件夹,检查venv内的python虚拟环境是否正确创建了。

同时可以手动按行执行一下rknn_yolo_node.sh这个bash文件中的指令内容,看是哪一行出了问题。