@贝壳 一般电脑按f2、f10、f11这三个键中的一个,小强pro是f11,有其它问题欢迎进入技术群538456117询问

ROS Group 产品服务

Product Service 开源代码库

Github 官网

Official website 技术交流

Technological exchanges 激光雷达

LIDAR ROS教程

ROS Tourials 深度学习

Deep Learning 机器视觉

Computer Vision

frank 发布的帖子

-

小强ROS机器人教程(15)___AMCL导航测试发布在 产品服务

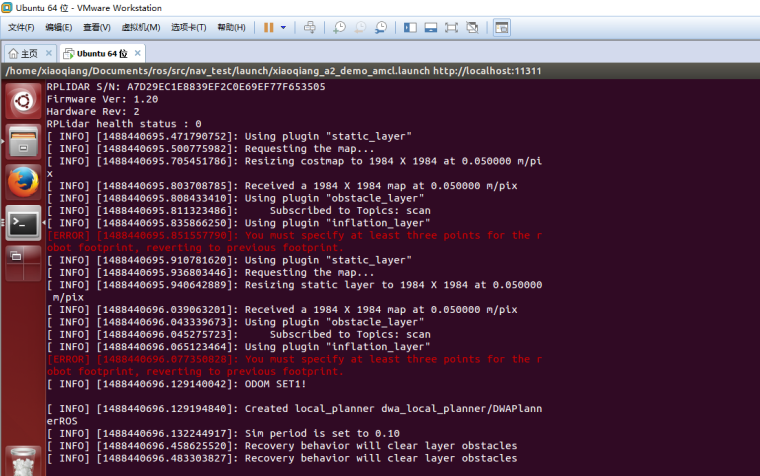

下文将演示AMCL导航操作,使用rplidar a2作为scan输入,教程14中建立的地图文件作为全局map

启动导航节点

先将教程14中建立的两个map文件拷贝到/home/xiaoqiang/Documents/ros/src/nav_test/maps/下,覆盖同名文件即可# 对于rplidar a1或者a2 roslaunch nav_test xiaoqiang_a2_demo_amcl.launch # 对于rplidar a3 roslaunch nav_test xiaoqiang_a3_demo_amcl.launch # 对于星秒pavo激光雷达 roslaunch nav_test xiaoqiang_pavo_demo_amcl.launch # 对于镭神ls01b激光雷达 roslaunch nav_test xiaoqiang_ls01b_demo_amcl.launch # 对于国科sc-mini或国科tof激光雷达 roslaunch nav_test xiaoqiang_scmini_demo_amcl.launch # 对于timoo 16线3d激光雷达 或者速腾3d激光雷达 roslaunch nav_test xiaoqiang_timoo_demo_amcl.launch正常会出现下图的类似结果,同时雷达开始旋转

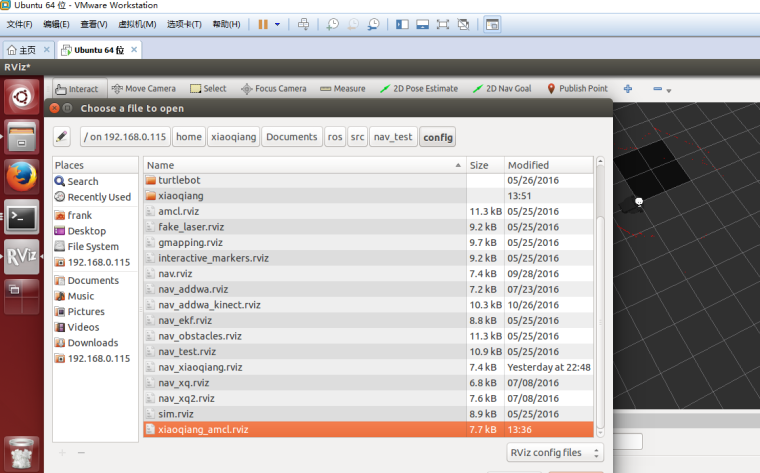

三、打开操作客户端

1.在机器人中启动rviz,选择打开小强ros工作目录下的

nav_test/config/xiaoqiang_amcl.rviz配置文件rviz

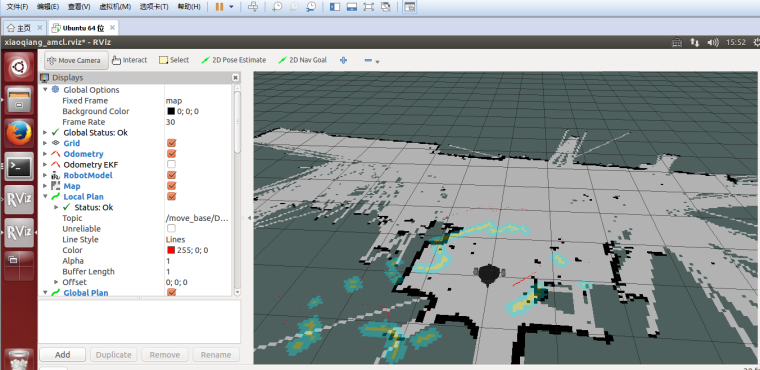

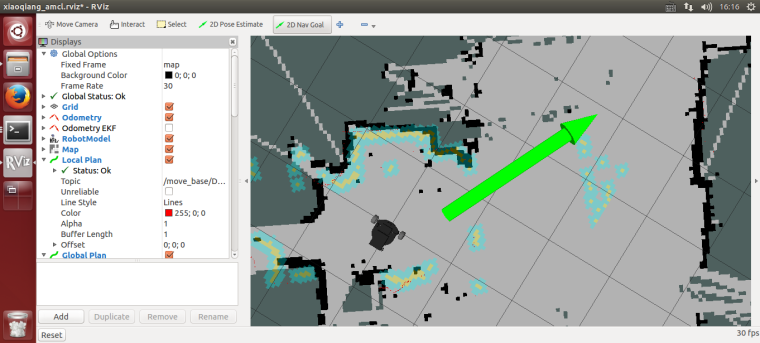

2.等待几秒后,rviz正常会出现类似下图的界面

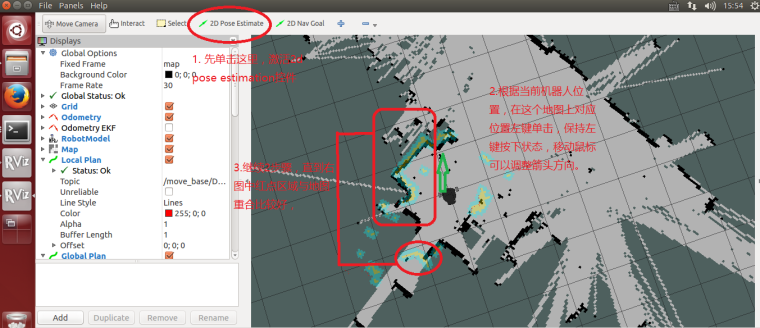

四、开始导航测试

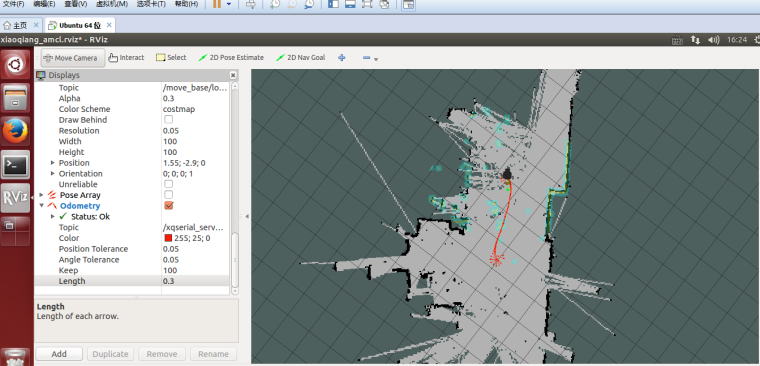

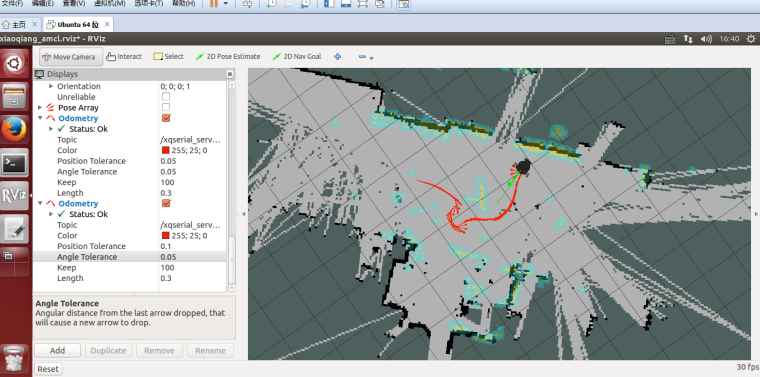

1.在rviz中使用2D Pose Estimation设置机器人的初始pose在map中的位置,因为AMCL算法需要一个较为精确的初始值,才能进一步由当前雷达扫描点阵匹配出机器人在map中的真实位置。

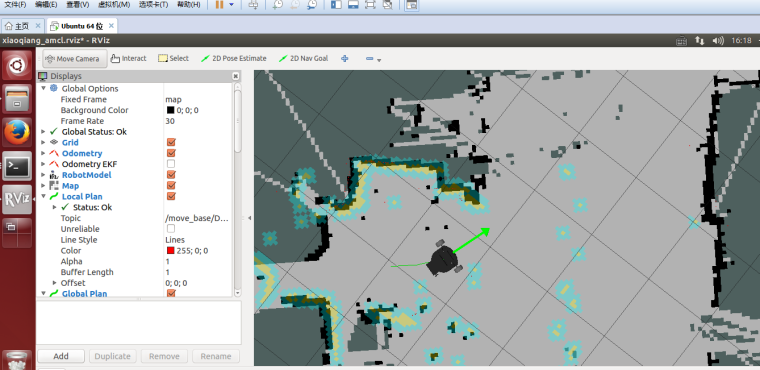

2.在rviz中使用2D Nav Goal 给小强发布目标点

3.小强开始自主移动到指定位置

五、请自由设置小强的2D Nav Goal,观察小强的运动情况,本文结束

-

小强ROS机器人教程(14)___在gmapping下使用激光雷达进行建图发布在 产品服务

1、 vnc登录小强主机

2、启动gmapping节点

确保雷达安装正确,vnc进入小强主机后启动gmapping中的launch文件

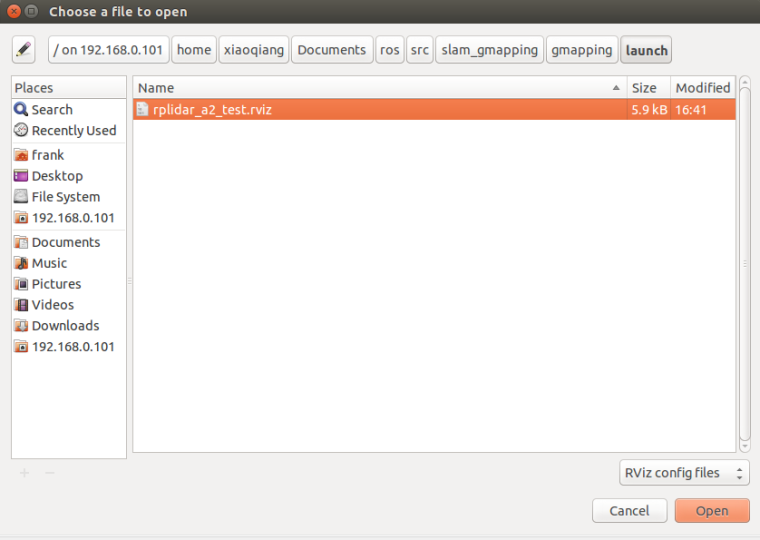

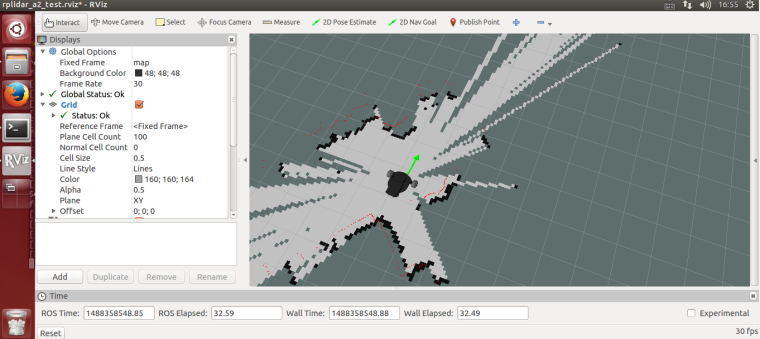

如果是rplidar a1或者a2 roslaunch gmapping slam_gmapping_xiaoqiang_rplidar_a2.launch # 如果是rplidar a3则启动 roslaunch gmapping slam_gmapping_xiaoqiang_rplidar_a3.launch # 如果是星秒pavo激光雷达 roslaunch gmapping slam_gmapping_xiaoqiang_pavo.launch # 如果是镭神ls01b激光雷达 roslaunch gmapping slam_gmapping_xiaoqiang_ls01b.launch # 如果是国科sc-mini或国科tof激光雷达 roslaunch gmapping slam_gmapping_xiaoqiang_scmini.launch # 如果是timoo 16线3d激光雷达 或者速腾3d激光雷达 roslaunch gmapping slam_gmapping_xiaoqiang_timoo.launch机器人打开rviz,选择打开小强ros工作目录下的slam_gmapping/gmapping/launch/rplidar_a2_test.rviz配置文件

rviz

等待几秒,正常情况会出现下图的类似结果

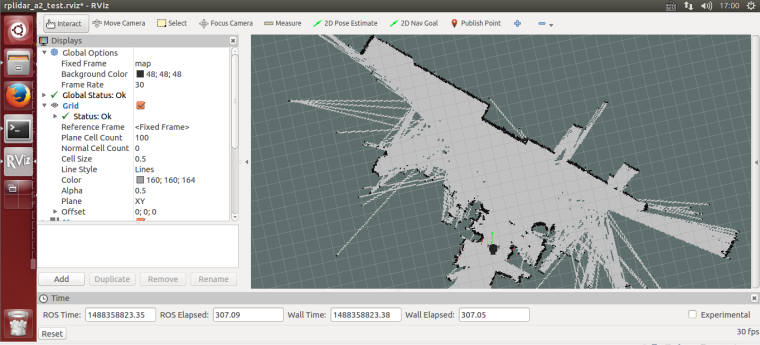

3、遥控小强运动开始建图

第一种方式,使用windows遥控端,参考这篇帖子(小强图传遥控windows客户端)

第二种方式,使用手机app,参考这篇贴子(小强手机遥控app安卓版)

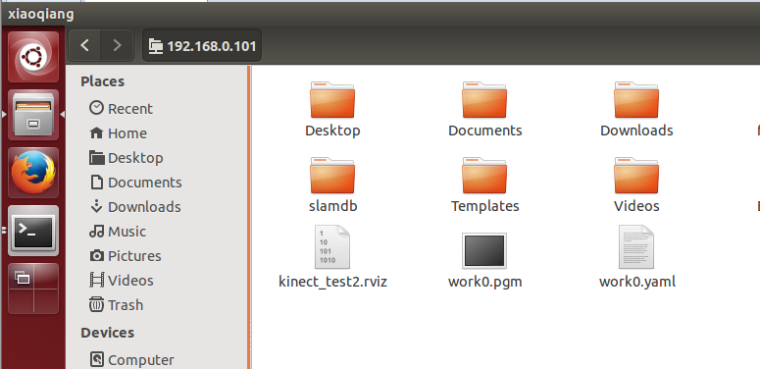

4、保存地图,本文结束

vnc登录小强,在小强home目录下保存为work0开头的文件

rosrun map_server map_saver -f work0

-

获数百万美元A轮融资,机器视觉公司速感科技欲在今年实现千万级营收发布在 行业动态

于2014年完成了天使轮融资,2015年完成了pre-A轮融资的速感科技,近期宣布正式完成数百万美元A轮融资。本轮融资由美国中经合集团(WI Harper Group)领投,启迪之星、赛富亚洲、深圳弘昇基金等机构跟投。

速感科技成立于2014年7月,是一家以机器视觉为核心的人工智能初创公司。在经历了两年多的研发期后于2016年10月推出了主要面向消费级电子产品的三维视觉传感器模组。这款视觉模组的高配版主要会应用在VR头显端,而低价低配版的目标应用产品则是有较大潜在市场的低端扫地机器人。

在去年11月,速感科技又马不停蹄的推出了面向工业级产品的传感器导航定位模块Inbox

,其主要应用对象是室内仓储机器人。Inbox

,其主要应用对象是室内仓储机器人。Inbox 要赋予仓储机器人视觉功能,并在特殊情况下帮助它选择合适的路径、检测路径上的障碍物。

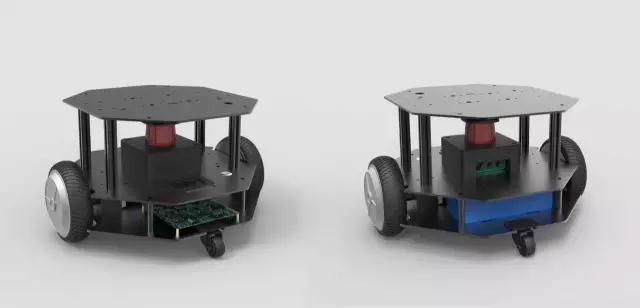

要赋予仓储机器人视觉功能,并在特殊情况下帮助它选择合适的路径、检测路径上的障碍物。除了以上两款产品,速感科技还联合英特尔研究院面向开发者推出了Xbot

机器人移动开发底盘。这款移动开发底盘主要是用于服务型机器人的二次开发,底盘上的开发接口开放,开发者可以快速完成机器人各项功能的部署。

机器人移动开发底盘。这款移动开发底盘主要是用于服务型机器人的二次开发,底盘上的开发接口开放,开发者可以快速完成机器人各项功能的部署。据悉目前几款产品均已供货,并预期在2017年实现千万级销售。乐观的销售预期除了取决于较好的视觉定位效果,还取决于速感科技对成本的良好把控,较低的成本会有助于B端客户快速实现量产及应用。

本文来源:http://36kr.com/p/5065211.html

-

受益AI和无人驾驶,英伟达Q4净利暴增至6.55亿美元发布在 行业动态

雷锋网消息:英伟达(Nvidia)今日(2月10日)公布了截至1月31日的2016财年第四财季财报。报告显示,公司该季度营收为21.73亿美元,去年同期为14.01亿美元,同比增长55%;按美国通用会计准则计(GAAP),净利润为6.55亿美元,去年同期为净利润2.07亿美元,同比增长216%;合摊薄后每股利润为0.99美元,去年同期为每股利润0.35美元,同比增长183%。英伟达是全球知名的图形芯片(GPU)厂商,一直以来在高端游戏PC市场占据主导地位。2008的时候,英特尔决定将推出集成显卡的芯片,英伟达的芯片生意几乎一夜之间消失。

自上市以来,在过去的17年中,英伟达的股价几乎从未超过35美元,但是截至雷锋网(公众号:雷锋网)发稿时间,它的股价已经突破116亿美元。从低谷到爆发,这一切都归功于人工智能和无人驾驶领域对GPU需求的爆发。

2008年,当时在斯坦福做研究的吴恩达发表了一篇用GPU上的CUDA进行神经网络训练的论文。2012年“深度学习三巨头”之一Geoff Hilton的学生Alex Krizhevsky用英伟达的GeForce显卡在ImageNet中将图像识别准确率大幅提升,这也是黄仁勋时常提到的英伟达重注深度学习的开端。

得益于图形芯片需求增加和无人驾驶系统及人工智能等领域的快速增长,英伟达的营收已经连续第二个季度增幅超过50%,并超出分析师预期。第四财季内,该公司GPU部门营收增长57%,达到18.5亿美元,为英伟达贡献了超过3/4的总营收。

此外,英伟达数据中心业务仍然增长迅猛,营收增长两倍多,达到2.96亿美元。亚马逊AWS、微软Azure、阿里云都是该公司的客户。GPU的优势在于不但可提升服务器的运行速度,而且能够降低数据中心的成本。

而英伟达汽车业务营收第四财季增长37.6%,达到1.28亿美元。此前,英伟达已经与特斯拉的Autopilot系统签订了芯片供应协议,之后特斯拉的全系车型都将使用英伟达的Drive PX2平台。除特斯拉之外,英伟达还与奥迪、百度等公司在自动驾驶领域展开了合作。

-

Udacity开源了“无人驾驶模拟器”,程序员“自学成才”的机会来了|潮科技发布在 行业动态

如果有丰富的无人驾驶教育资源与开放的虚拟测试平台,你愿意自学成为一名软件工程师吗?有一个词,可以恰到好处地证明目前无人驾驶汽车领域的用人状态:饥渴。

事实上,我们在过年期间在对“特斯拉状告前员工的诉讼”中就详细描述过这种相关技术人才稀缺的“买方市场”:

在入局玩家只增不减,且规模不断扩大的前提下,无人驾驶人才的行情只会看涨不跌。

因此,无论是收购,还是招聘,包括Google、特斯拉、Uber在内的各家公司,其动作幅度都比以往要大的多。更好玩儿的是,这些公司不惜对簿公堂,也要尽可能挖对方的墙角。

据《今日美国》报道,截止2016年2月,数十家技术或汽车公司贴出的职位超过400个,其中,一大半职位偏向于软件工程与算法方向,但也有不少汽车动力建模、涡轮机制造与现实捕捉处理等方向的职位。

本来就是新技术,“缺人”倒是情有可原。但既然缺人才,就需要有一个稳定的“货源”,以丰厚的教育资源为基础,向市场输出人才。

没错,Google无人车之父Sebastian Thrun 在离职后创办的在线教育机构Udacity就是出于这个目的建立起来的:

2016年9月,它与滴滴、奔驰、英伟达等公司合作,推出了一项无人车的“纳米学位”(nanodegree program)计划。学员接触的课程涉及到多个学科知识,包括计算机视觉、机器人、智能系统、人工智能等方向。

但是,由于这项计划在全球仅有250个招生名额,绝大多数程序员与技术爱好者其实无法享受到Udacity提供的教学资源。

然而,就在昨天,这家具有“慈善味道”的教育机构表示,将通过开放原始码版权,将自己的无人驾驶汽车模拟程序无偿开放给全球所有程序员。

换句话说,只要你具备一定的系统知识与资源,就可以在这个无人车模拟器中加载预存场景,为汽车软件的虚拟测试创建自己的轨道。

咦,这难道不是一个“无师自通”,自主开发无人车软件的好机会?

开放虚拟训练平台,这是一张面向开发者的“英雄帖”

如果你正在持续关注这个领域,就应该了解到,大量自动驾驶汽车软件只能在虚拟环境中进行训练与测试。

原因很简单,毕竟先制造一辆自动驾驶实物原型车的成本实在太高,大多软件开发者并没有像Uber及特斯拉那样雄厚的财力。

此外,从政策监管的层面考虑,找到一个能允许你上路实测的地方也实在困难,毕竟连Uber的无人车都在被西部几个州赶来赶去(你必须要在实地路测前,对软件的安全水平有一个合理的预期)。

以上对一些创业公司或个体开发者来说,是两道难以逾越的障碍。

因此,Udacity的这个举动对很多开发者来说的确一场“及时雨”。实际上,这与“无人车纳米计划”想要实现的终极目标是完全一致的——打造一辆开源式无人驾驶汽车。

而驱动这辆无人车的大量软件代码,需要由来自全球成百上千名程序员利用开源平台来完成。因此,这次开源行动,本质上就是一次面向全球无人驾驶软件开发者发布的“英雄帖”。

其实,早在去年9月,Udacity就曾透露过一些开源细节——自己正在利用一辆2016款林肯MKZs开发模拟器程序。

有意思的是,这款车型其实在无人驾驶软件及组件公司颇受欢迎,原因就是一家第三方平台正在打算基于这款车来开发自动驾驶转换器。

所以,这次正式开源恰恰是Udacity开发态度的一次新的延伸——不仅仅是为了培训人才,而是主动为开发者社群提供一种更加基础的训练工具来解决这项浩大且复杂的工程。

不得不提的是,一些重要的其他环境模拟工具,譬如具备了超现实交通系统的知名游戏《侠盗猎车手5》,已经被证明可以为自动驾驶软件“预演”提供有价值的虚拟环境。

但开发者们一定不会拒绝更加多样化的训练平台,特别是出自Google无人车之父Thrun之手的模拟器,无疑将会受到程序员们的欢迎与好评。

据 Thrun 估计,仅技术产业对无人车工程师的需求就将近5000人。如果考虑全行业需求,大概会超过20000人。

这样来看,通过开放模拟器制作软件,捕捉数据来“自学成才”,也可以成为圈子里的新趋势。

本文来源:http://36kr.com/p/5063487.html -

把马赛克变成高清无码大图?Google这款AI小软件让人眼前一亮|潮科技发布在 行业动态

下图是城市的夜景,你能看清楚吗?谷歌的这项AI技术可以帮助你

谷歌大脑近日发布了一个可以把马赛克照片还原清晰的软件。看样子是个让人很有联想的应用。岛国的爱情动作片飘过眼前,有了这款软件是要彻底攻占骑兵的堡垒,宣告步兵的胜利吗?

是的,你看到了一篇假文章。

严肃脸:下面我们开始认真研究一下谷歌的这款人工智能产品。

其实,把模糊照片放清楚,是有着很实际的用途的。比如说,缉拿犯罪嫌疑人的时候,没有足够清晰的照片,可以借助这项功能将照片放大,从而给警方提供更多的线索支持。

谷歌大脑的这款新产品就可以在这方面提供一些颇有价值的帮助。现在他们已经成功将8*8(毫米)网格的像素马赛克转换成为肉眼可辨识的人物图像。这项技术叫做“像素递归超分辨率”技术(Pixel Recursive Super Resolution)。

以这组图片为例。最右侧是32 x 32像素的真实图片,左侧是已经压缩到8 x 8像素的图片,中间的就是通过这项技术还原的结果。结果不算很理想。还原过的图片和真实的图片看起来像是两个人,但是比起左侧的模糊图片,已经好太多了,左侧的图片单独来看完全看不出什么内容。

谷歌大脑是怎么做到的呢?它聚合了两种神经网络,来补充图片的细节。

第一部分是条件网络(conditioning network)。比如,在上面这个案例中,它会将8×8的图片与高清图片进行对比,将其他高清图片缩小到8×8的分辨率,寻找图案、颜色的相似关系。

第二部分是优先网络(prior network),使用PixelCNN(像素神经网络)向8×8的源图片中增加真实的高清细节。在上面的例子当中,优先网络就吸收了大量的名人照片。

然后,当需要解析源图片时,便会从其已知的图片中寻找与之匹配的新像素,并将添加进去。例如,图片顶部有一个棕色像素,而优先网络或许认为那是一条眉毛:于是,当要解析图片时,就会用眉毛形状的棕色像素填补进去。

为了制作出最终的无码高清图片,需要融合这两个神经网络输出的数据。总结来说,就是通过学习大量图片,获得给照片补充细节的能力。OK,这多少有点类似于P图去水印还原图片的过程。

谷歌团队测试了呈现效果。向人类展示高清明星照和还原照片时,人类观察员被骗的比例达到了10%,而达到50%就属于完美得分。

在卧室照片的同类对比中,观察员被骗的比例达到28%。这个得分怎么样?

此外,谷歌也对比了另一个还原照片的技术——双三次插值放大技术,这项技术没有骗过任何一个观察员。

当然,还原的图片肯定不同于真实的图片,会有一些额外添加的细节,这在图像处理领域里术语被称作“幻象”,只是计算机的“猜测”,换句话说,系统认为新图片的清晰度足以“欺骗”人类的眼睛。但是,新添加的细节很可能与事实有别,似是而非。

不过,这项技术也有让人担心的地方。随着这项技术的成熟,肯定可以让还原照片高度接近真实照片。这样的话,网上流传的一些模糊处理的照片就失去了价值,可能导致当事人隐私泄露,带来人身财产的安全隐患。

-

下一个颠覆汽车行业的技术?聊聊轮毂电机的前世今生发布在 行业动态

引言

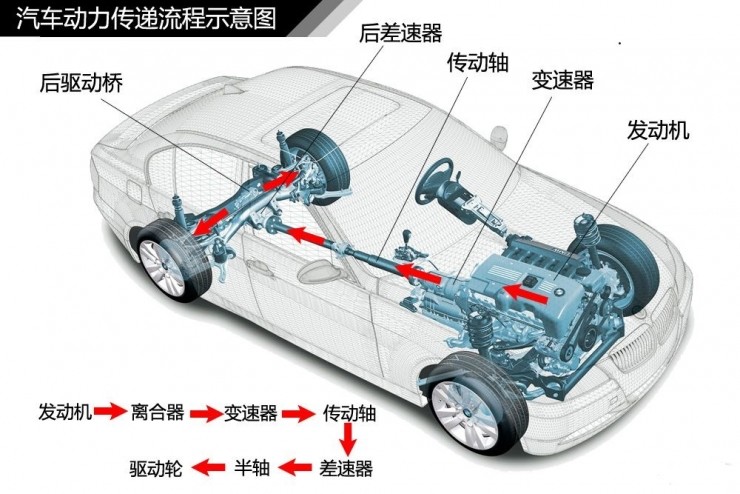

随着汽车的新能源化,汽车的结构更加简单了,简单到只需要电池包和电机就可以替代传统的发动机了。可是,除了离合器和变速箱结构简化外,传动系统还是非常复杂,尤其是四驱车辆。

但是,有一项技术能淘汰全部传动系统,你敢信?

没错,就是轮毂电机!

轮毂电机定义

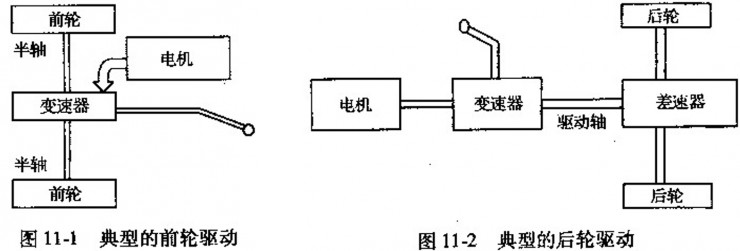

传统电动汽车的传动方案是把电机的输出扭矩通过变速器和差速器等传递到车轮。

传统电动汽车传动方案

有童鞋可能会说,为什么这么复杂,把电机直接装在轮子上不就行了吗?

Bingo! 轮毂电机的技术就是将电机装在轮毂内,不经过任何机械结构的传递,直接驱动车轮。就是这么简单粗暴!

Protean轮毂电机爆炸图

轮毂电机的优点

轮毂电机通过把电机集成在轮毂内,高度集成化,具有以下优点:

高效率

传统的传动系统由于结构的复杂性,每一级传动都有传动效率的损失,总体传动效率的损失还是很大的。而轮毂电机直接驱动车轮,避免了传递路径上效率的损失,可以提升效率,节省能量。数据显示,相对于传统的传动系统来说,轮毂电机可以提高8%~15%左右的效率。

对于电动汽车来说,效率的提升可以进一步增加续航里程。或者保持续航里程不变,电池么,就做小一点。另外,虽然轮毂电机比普通轮毂要重不少,但是对整车来说,还是减重很多的。对于电动汽车来说,减重意味着续航能力的增加,就可以把电池做的再小一点了。

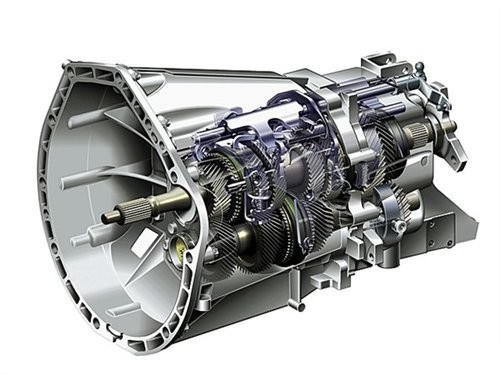

空间布置

由于高度集成化,省去了中间一大坨传动机构,可以节省前舱的布置空间,以及四驱车辆的后排座椅的凸起,乘客可以享受更大的车内空间。上面那一坨变速箱就不需要了,前舱秒变行李舱不是梦。后驱车后地板上的“迷之突起”消失,啪啪啪更方便。

方便控制

由于电机直接驱动车轮,MCU(电机控制器)只需要一个简单的指令就可以直接控制车轮的转速和扭矩(而且精度非常高),可以很容易的实现非常复杂的控制。比如可以通过左右轮不同转速甚至反向旋转来实现差动转向,可以大大减小车辆的转向半径,甚至可以实现原地转向(不过对轮胎的磨损比较大)。另外,对于装备有四轮轮毂电机的车辆,可以更容易实现更高水平的制动能量回收利用率。理论上,如果轮毂电机扭矩足够大,可以回收100%制动能量,只是受限于电池组的充电功率。

成本

理论上,由于节省了复杂的传动机构,机构更简单,零件更少,整车成本会下降。但是目前由于轮毂电机产业化还远远不够,而且技术被少数公司垄断,轮毂电机成本还居高不下。不过随着轮毂电机前景被各大车企看好,一步步实现产业化,这部分优势会逐渐体现出来。

模块化

由于轮毂电机的高集成度,轮毂电机理论上只与车轮大小有关,所以更容易模块化,避免重复开发,可以缩短新车型的开发周期和开发费用。

轮毂电机的缺点和挑战

轮毂电机也存在一些缺点,遇到一些挑战。

簧下质量增加

簧下质量的增加对操控性能的影响,主要体现在:

颠簸路况时悬架的响应会变慢

轮毂转量增加使加速响应慢

对于第1点,普通家用轿车不太敏感,对于更高级别的车辆,可以通过优化悬架结构来改善。至于说的第2点,电机本身的低转高扭特性可以弥补这一点。

防震防水防尘的挑战

由于电机内置在轮毂里,工作环境要恶劣的多,而电机本身比较娇贵,所以对于防水防尘防震设计要求就很高。

冷却/散热的挑战

之所以要散热,一是因为本身电机工作会产生热量,二是机械制动时会产生大量热量。

问:不是轮毂电机可以实现100%制动能量回收吗?为什么不取消机械制动结构?

答:虽然理论上可以实现100%的制动能量回收,但是实际上不能取消传统制动结构。

原因如下:

轮毂电机的制动力矩不可能满足紧急制动的需求,跑车级别的驱动加速度能做到0.5g,就很可观了,而紧急制动时减速度很容易就能达到0.9g~1.1g。所以轮毂电机提供的制动力矩是远远不够的。

制动能量回收受制于电池的SOC(State of Charge,即剩余电量水平),在电池电量接近满电时,一般控制逻辑里是不会进行能量回收的。即使控制逻辑上可以实现满电时仍可以进行能量回收,为了确保电机故障时仍能保证车辆安全,传统机械制动结构还是必要的。

机械制动时,其原理本质为机械能转化为热能,瞬间会产生极大的热量,短时间内造成周边温度的大范围上升(连续制动时可以到300度以上)。电机的永磁体对温度非常敏感,温度太高会造成消磁,这会对电机造成破坏,一般轮毂电机采用水冷方式来保护电机。

此外,温度的上升也会造成制动性能的热衰退。由于轮毂电机的结构形式,导致轮毂电机的散热效果不如传统轮毂的散热效果好,这对制动系统的设计提出了挑战。

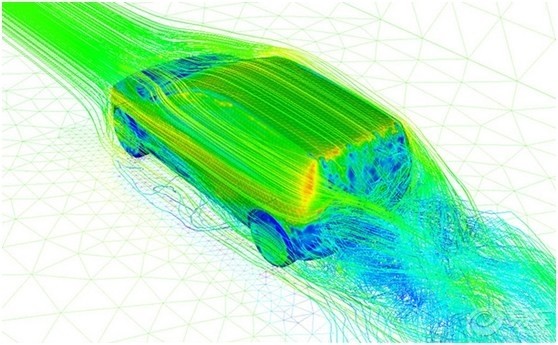

不过话说回来,轮毂电机封闭的轮辋造型,可以让空气更加平滑的通过车身,从而最大程度的降低风阻。

轮辋造型对风阻系数影响示意图

一般车辆的轮辋考虑散热,轮辐之间空挡较大,造型是酱婶的(见下图)。

普通车轮的轮辋造型

而为了降低风阻,BMW i3的轮辋造型是酱婶的。

BMW i3轮辋造型

超低的0.19cd的风阻系数的奔驰IAA概念车,轮辋造型是酱婶的。

奔驰IAA概念车轮辋造型

好吧,轮毂电机结构的轮辋造型是介个样子的。

Protean轮毂电机轮辋造型

轮毂电机的发展现状

国际巨头的成果

2013年,福特与汽车零部件厂商舍弗勒共同开发搭载轮毂电机驱动技术的后驱嘉年华。用在嘉年华上的轮毂电机,单个重量为53千克,比传统车轮装置的重量高不少。

舍弗勒的轮毂电机采用水冷设计,单个电机最大功率40千瓦(54马力),电机工作时平均输出功率为33千瓦,两台电机的最大功率为80千瓦(40×2),约109马力,连续输出时的平均功率为66千瓦(33×2),即90马力,输出扭矩可达700牛米。

目前国际上著名的轮毂电机生产厂商有英国的Protean电机公司、加拿大的TM4公司、著名的轮胎生产商米其林公司和日本的普利司通公司。

其中,英国的Protean电机公司是一家专门研发生产轮毂电机的公司。其生产的轮毂电机能够实现75kW的峰值功率和1250NM的峰值扭矩,质量为36kg,可安装在直径为18英寸以上的车轮中,能回收高达85%的制动能量。

据了解,Protean已与多家整车厂商合作研发了多款装配轮毂电机的样车和改装车型,包括福特F150-EV、VolvoC30 SeriesHEV、沃克斯豪尔Vivaro货车、广汽传祺mmpchiEV以及基于梅赛德斯奔驰E级的巴博斯纯电动与混合动力车型。

国内零部件企业的布局

万安科技与Protean股权合作战略布局轮毂电机技术,欲开发16寸轮毂的轮毂电机,以加速推进轮毂电机技术在国内落地和产业化。

亚太股份以参股方式投资斯洛文尼亚轮毂电机技术公司1000万欧元,占该公司股份的20%。双方同意在中国成立合资公司,亚太股份占该合资公司51%的股份,欧盟公司占该合资公司49%的股份。亚太可以利用欧盟斯洛文尼亚轮毂电机技术公司的技术在中国打造本土化产品,推动中国新能源汽车产业的发展。

总结

由于轮毂电机具有高效率,高集成度的优点,与新能源汽车十分契合,在新能源汽车领域有非常好的发展前景。不过,由于轮毂电机增加了簧下质量,会影响车辆的操控性能,此外,还有很多防水防尘防震和散热的挑战需要克服。

总之,由于轮毂电机还没有大规模量产,成本居高不下,推广普及还需要一定时间。对于传统车企来说,一直以来的传统是,传动归传动,驱动归驱动,底盘归底盘,分属不同的部分,泾渭分明。一旦普及,传动系统将取消,驱动和底盘将深度融合在一起,对于传统车企的组织架构是一个非常大的挑战。传统车企想要推动这个变革,其决心不亚于壮士断腕。

面对多变的世界,悠久的历史和庞大的规模对于传统车企来说,是一个负担。是时候摆脱束缚、轻装上阵了。

-

RE: 小强ROS机器人教程(10)___使用kinect进行自主移动避障发布在 产品服务

如果小强一直后退,rviz中可以看到小车前面有一块黑色区域,黑色区域一直跟随小车移动。这种情况说明kinect安装或者kienct低头角度没有到位,请检查kinect安装支架、去除kienct贴膜后重新执行教程中的指令

-

RE: 小强ROS机器人教程(10)___使用kinect进行自主移动避障发布在 产品服务

请将kinect数据线插入小车主机蓝色usb3.0端口,才能保证驱动的正常工作。型号为1473的kinect用户请先看教程(9)中的准备办法,在成功发布角度之后(kinect低头)需要关闭这个角度发布命令,不关闭会导致kinect深度点云数据没有输出。

-

RE: 小强ROS机器人教程(8)___kinect1代 ROS驱动测试与安装发布在 产品服务

@大水怪 sorry,没遇到过这种情况,如果你不需要kinect的音频输入,可以将命令中的-DBUILD_REDIST_PACKAGE=OFF去掉后重试

-

RE: 坐标融合算法能不能具体讲讲呢?发布在 讨论区

@zhu

融合算法的思想是根据同一时刻,视觉odometer和底盘惯导odometer之间的变换关系是固定不变的(由安装位置决定),这可以列出一个方程。多个时刻的数据就能获得多个方程,多个方程组求解即可得到这个变换关系。得到变换关系后,两个odometer现在已经在同一个坐标系下了,可以进行加权或者卡尔曼滤波融合 -

中国自动驾驶初创公司Momenta获500万美元A轮投资发布在 行业动态

位于北京的自动驾驶初创公司Momenta获得500万美元A轮投资,本轮由蓝湖资本领投,创新工场和真格基金跟投。

Momenta成立于今年9月初,是一个致力于打造无人车大脑,专注基于深度学习的环境感知、高精度地图、驾驶决策技术的团队。产品包括不同级别的自动驾驶方案,以及衍生出的大数据服务。

Momenta团队来源于清华大学、麻省理工学院、微软亚洲研究院等。其中有世界顶尖的深度学习专家,例如图像识别领域最先进的框架Faster R-CNN和ResNet的作者,mageNet 2015、MS COCO Challenge 2015多项比赛冠军。因此团队拥有深厚的技术积累和极强的技术原创力。

Momenta CEO曹旭东毕业于清华大学。创立Momenta之前,他先后任职于微软亚洲研究院和商汤科技,有近百人研发团队管理经验以及丰富的产品落地经验。其研发技术用于Xbox,Bing,How-old等知名产品,亦对无人驾驶环境感知,对高精地图,驾驶决策有深入研究。

面对最近Uber等无人车试运营消息,曹旭东表示人们误以这些公司已经开始商业落地,但其实本质上这些公司是在做无人车的路测。如果没有解决无人车大规模数据收集和测试的关键问题,路测到商业化落地之间的巨大鸿沟就会一直存在。

曹旭东认为无人驾驶最重要的优势是安全。据统计,全球人类司机一亿公里发生致命事故一至三起。而无人驾驶其实可以做到致命事故率低一个量级,做到十亿公里一起致命性事故。

不过目前做到无人车系统的安全性,最大的难题在于大规模数据收集和测试的巨大成本。因为一套无人驾驶系统需要测试的总里程要达到1000亿公里。按照一辆车一年10万公里总里程计算,系统测试一年需要100万辆车来收集无人驾驶数据和测试,才能够保证无人驾驶所需要的安全性。而一辆无人车的成本都在百万人民币,乘以100万辆车这个巨大的基数,对于任何一家公司而言,都是一个天文数字。

Momenta在解决这一难题上采取了两个办法:一是无人驾驶模拟;二是众包数据收集和测试。无人驾驶模拟可以通过算法生成感知和决策数据,减少数据收集和测试车辆数量,降低研发成本。众包其实特斯拉和Mobileye就在做,但是这几家公司存在着需要承担造车成本、读取和控制车辆驾驶行为的数据、安全事故等问题,因此在时间上显著慢于算法研发节奏,安全性上并不稳定。Momenta则通过高精度地图来预测和记录驾驶轨迹,如果预测轨迹和真实轨迹比对一致则说明测试通过,否则则失败。这种做法既不控制车,也不带来危险,就可以实现众包测试。

领投的蓝湖资本合伙人胡磊表示:“自动驾驶是未来发展的趋势,根植于深度学习的自动驾驶技术拥有广阔的前景和商业空间。因此,拥有世界级原创科技研发能力的Momenta具有强大的潜力和独特性。”本文来源:http://tech.qq.com/a/20161114/030058.htm

-

ubuntu循环登录,无法login的解决办法之一发布在 技术交流

执行下述命令,然后重启

sudo apt-get purge nvidia* sudo apt-get install -f #重装搜狗输入法 -

英国初创公司 Graphcore 融资 3000 万美元资金,用于研发和生产人工智能专用芯片NPU发布在 行业动态

近日,一家生产 AI 芯片的英国初创公司 Graphcore 融资 3000 万美元资金,用于研发和生产新型芯片。

Graphcore 计划明年大规模出货,其芯片将用于对机器学习和深度学习运算需求较高的无人驾驶汽车和云计算领域。Graphcore 称,他们的芯片性能可领先市场同类产品的 10 ~ 100 倍。

Graphcore 是从芯片厂商 XMOS 中孵化,XMOS 在物联网高性能芯片领域有着一定的积累, 2014 年曾获得华为和德国工业巨头博世以及 Xilinx 的投资。

作为一个从传统芯片厂商独立出来的技术团队,Graphcore 首席执行官 Nigel Toon 也十分自信,声称当前 GPU 常被用来运行机器学习程序,只是行业的权宜之计,这并不见得是最好的选择,它们往往无法满足 AI 的需求。GPU 被设计成用来运行完整的程序,而机器学习与此完全不同。后者是不断训练程序使用数据的过程,需要完全不同类型的处理器。

雷锋网(公众号:雷锋网)此前曾在《芯片之争:CPU、GPU、DSP、NPU,到底哪个更适用于深度学习?》一文中提到:

无论是针对人工智能的众核芯片还是定制版的 GPU,本质上都不是专用处理器,实际上是拿现有的、相对成熟的架构和技术成果去应对新生的人工智能,并没有发生革命性的技术突破。

英特尔和英伟达是在使用现有的比较成熟的技术去满足深度学习的需求,众核芯片和定制版 GPU 在本质上来说依旧是 CPU 和 GPU,而并非专门针对深度学习的专业芯片,这就必然带来一些天生的不足。打个比方,用众核芯片和 GPU 跑深度学习,就类似于用轿车去拉货,受轿车自身特点的限制,货物运输能力与真正大马力、高负载的货车有一定差距。同理,即便是因为技术相对更加成熟,英特尔和英伟达的芯片在集成度和制造工艺上具有优势,但由于 CPU、GPU 并非针对深度学习的专业芯片,相对于专业芯片,其运行效率必然受到一定影响。

为此,Graphcore 正着力打造新的智能处理单元(IPU)系统,并计划于 2017 年推出。根据官方介绍,其 IPU 围绕神经网络计算加速处理器(Neural Network Accelerator),支持的并行计算规模和浮点运算精度比其他芯片更高。

当然,关于 Graphcore 自称其 IPU 芯片性能均领先市场同类产品的10 ~ 100 倍这一说,还需经过市场考验。其实 NPU 也一直被业内认为将在人工智能演进过程中扮演的关键角色,如寒武纪团队过去和 Inria 联合发表的 DianNao 论文提到,CPU、GPU与 NPU 相比,会有百倍以上的性能或能耗比差距。

但目前国内外均还未有主流的 NPU 厂商出现。高通曾对外宣称将大力发展 NPU,并称在 2014 年推出样品,随后却不了了之。虽然 2016 年涌现出多家进军 NPU 的芯片厂商,但无论哪家推出的芯片,均需要一定的验证和测试周期。因此 Graphcore 的 IPU 芯片在量产后是否能够表现优秀,仍有很多未知因素。

Toon 给出一个为社交媒体公司服务的案例,以证明 IPU 的实用性。Toon 提到,社交网络的用户活跃度通常在某个时间最为突出,Graphcore 的 IPU 系统会伺机在用户活跃度低时利用闲置的处理器资源进行 AI 训练,然后在第二天及时地上线新内容。

Graphcore 也并非一个人在战斗,Bosch 和三星作为 Graphcore 的战略投资方,两者均在与 Graphcore 探讨合作:Bosch 意在借助 Graphcore 的技术拓展自动驾驶领域,而三星投资它的目的想把其相关技术应用在下一代网络设备中。

本文来源:http://www.leiphone.com/news/201611/De4XGarFTlmLlGv0.html

-

速感科技发布三维视觉传感器ULBrainTM-32发布在 行业动态

近日,机器人视觉技术与人工智能初创公司速感科技向媒体透露,将推出团队研发的第一代机器人三维视觉传感器ULBrain?M-32。自2014年7月创立以来,速感科技团队致力研究VSLAM(基于视频的即时定位与地图构建)算法,以及该技术在芯片端,以及在整套机器人产品中的集成。

ULBrain M-32的推出,正是他们集中在该领域长时间研发的一个阶段性成果。据悉,ULBrain

M-32的推出,正是他们集中在该领域长时间研发的一个阶段性成果。据悉,ULBrain M-32传感器预计售价为1200元人民币,其搭载的深度摄像头、IMU(惯性测量单元)及9轴陀螺仪,使定位精度最高达到1cm,远近探测距离范围分别是8米和0.3米。而区别于目前竞品VSLAM方案中需要额外配置一台电脑,处理并呈现最后的定位信息,ULBrain?M-32中搭载的芯片级视觉处理单元,以更低成本和更高效率完成对定位信息的解算。因此在性能方面,它具备更高的定位能力,目前比较适用于中高端机器人产品。

M-32传感器预计售价为1200元人民币,其搭载的深度摄像头、IMU(惯性测量单元)及9轴陀螺仪,使定位精度最高达到1cm,远近探测距离范围分别是8米和0.3米。而区别于目前竞品VSLAM方案中需要额外配置一台电脑,处理并呈现最后的定位信息,ULBrain?M-32中搭载的芯片级视觉处理单元,以更低成本和更高效率完成对定位信息的解算。因此在性能方面,它具备更高的定位能力,目前比较适用于中高端机器人产品。

速感科技CTO张一茗告诉泰伯创客,基于激光投射器、红外摄像头和RGB摄像头所组成深度摄像头,其VSLAM定位技术的核心在于算法,包括红外传感器对激光透过毛玻璃发生散射后,对散射点捕捉和距离测量的算法,以及将该数据与RGB深度信息、IMU、陀螺仪测量信息的进一步整合后,对定位精度进一步提高的有关算法。(张一茗也曾在科技媒体雷锋网具体讲述SLAM技术原理和前景,详情可搜索《SLAM的前世今生终于有人说清楚了》这篇文章。)

另外值得一提的是,ULBrain M-32也适用于VR设备的室内空间定位。市场上,已经有激光扫描结合动作捕捉的可穿戴设备方案辅助VR用户在虚拟场景中的移动定位,例如泰伯网曾经报道过的VR服务商G-Wearables正是其一,但整体部署成本相对来说还要更高。

M-32也适用于VR设备的室内空间定位。市场上,已经有激光扫描结合动作捕捉的可穿戴设备方案辅助VR用户在虚拟场景中的移动定位,例如泰伯网曾经报道过的VR服务商G-Wearables正是其一,但整体部署成本相对来说还要更高。

速感科技COO贾小龙通过媒体表示,团队将集中力量推广ULBrain M-32这款高端传感器,但同时他们也在准备精度、性能减半,成本也相对更低的低端传感器,从而以多元化的产品协助打通市场,提高企业在机器人应用与服务领域的影响力。对于ULBrain

M-32这款高端传感器,但同时他们也在准备精度、性能减半,成本也相对更低的低端传感器,从而以多元化的产品协助打通市场,提高企业在机器人应用与服务领域的影响力。对于ULBrain M-32何时正式推向市场,贾小龙提到今年年底将有第一批产品对接B端市场的合作伙伴,而随着市场需求的增大和产能的提升,ULBrain

M-32何时正式推向市场,贾小龙提到今年年底将有第一批产品对接B端市场的合作伙伴,而随着市场需求的增大和产能的提升,ULBrain M-32的成本将有望降低到数百元人民币。

M-32的成本将有望降低到数百元人民币。

今年早些时候,速感科技CEO陈震通过泰伯创客提到他们正在为高档商超设计一款能自主导航定位的智能购物车Folo。陈震表示,团队始终致力思考VSLAM相关的应用场景,他们同时在跟英特尔、微软、暴风魔镜等公司交流,推进相应的合作。本文来源:http://info.secu.hc360.com/2016/11/021031872942.shtml

-

给仓储机器人一双“慧眼”,速感科技发布工业级导航定位模块发布在 行业动态

据悉搭载相应模块的机器人预计明年春节后面世。

11月1日在IAS工业自动化展会上,机器视觉解决方案公司速感科技联合德国激光雷达厂商倍加福(Pepperl+Fuchs)推出了工业级AGV导航定位模块,未来将主要应用于仓储物流行业。

这款AGV导航定位模块采用了速感科技自主研发的SIRVOTM4.0双机控制技术,可以同时接收其他传感器的数据信息并对导航定位结果进行修正。现阶段它已完成了所有可行驶的路径的差速驱动和全方位驱动测试,最快测试速度达到了2.3m/s,导航和定位效果均达到甚至优于市面流行的激光导航传感器产品。

这款AGV导航定位模块的技术关键是它集成了速感科技研发的嵌入式组合导航算法V3.0,这种激光导航算法是以激光雷达数据为主体并融合了多种传感器数据。它具备图形化用户界面,支持手动输入目标位置,同时支持多点巡航模式。它可以提高运输机器的可靠性和稳定性,并在特殊情况下帮助它选择合适的路径、检测路径上的障碍物。

从今年3月份开始,速感科技就开始在前端传感器上做算法的集成,采用的是含ARM和DSP的片上系统,速感科技CEO陈震介绍他们方案的优越性在于成本低,适合量产,可以更快的推出并且应用在B端客户上。

COO贾小龙表示即此次推出的第一代传感器主打效果,SLAM定位精度可以达到1%,帧频最高可达90帧,并且它的体积很小,更加方便用户设计。其定位也是高价路线,会应用于商业服务机器人等高端应用中。这款传感器也可以搭载在VR设备上做空间定位。

此外贾小龙也告诉36氪公司正在设计一款比较平价的传感器,预计半年到一年后发布。高价版与低价版的差别在于高价版传感器原材料都是进口的因此成本较高,而在低价版传感器上,他们会通过寻找合作的原材料供应商、对传感器的架构进行重新设计等方式降低成本。这款平价传感器将搭载在低端扫地机器等应用上。贾小龙也透露这款预研的低价版传感器已经有了意向客户。

贾小龙称国内的高端服务机器人市场规模大概能达到40-50万,这些高端服务机器人的生产厂商都是高价版传感器的潜在目标客户。而低端扫地机器人的市场规模大概是300-500万左右,它们的生产厂商则是低价版传感器的潜在目标客户。公司表示更倾向为机器人公司提供标准化模块,但也会为大型公司提供定制服务;

CEO陈震研究生就读于清华大学计算机系,长期与微软亚洲研究院保持技术合作,参与多项重大科研课题研究,并完成同多家互联网企业的项目合作。CTO张一茗,GAIR2016先锋100创业领袖,毕业于北京航空航天大学,拥有多年SLAM及其组合导航定位系统研究经验,国内资深机器人爱好者。COO贾小龙,清华大学应用金融学硕士,历任中国上市公司项目经理、高级项目经理、资深项目管理人,具有10年团队管理层经验,目前全面负责公司整体运营、对外合作、战略形态制定与品牌推广。

速感科技已于2014年完成了数百万的天使轮融资,投资方是点亮资本。2015年完成了pre-A轮融资,投资方为英诺天使基金。

原文出处:http://36kr.com/p/5055662.html