@zhaoyu24 cartographer_ros_msgs包没有编译成功或者source问题,参考https://github.com/googlecartographer/cartographer_ros/issues/1078

ROS Group 产品服务

Product Service 开源代码库

Github 官网

Official website 技术交流

Technological exchanges 激光雷达

LIDAR ROS教程

ROS Tourials 深度学习

Deep Learning 机器视觉

Computer Vision

Posts made by xiaoqiang

-

RE: google激光雷达slam算法Cartographer的安装及bag包demo测试posted in 产品服务

-

jetson nano 安装jetson-inference遇到nvidia.box.com无法连接的解决办法posted in 技术交流

删除build文件夹内的所有内容,使用下面的命令将nvidia.box.com替换成国内源。

#在jetson-inference源代码根目录内执行 sed -in-place -e 's@https://nvidia.box.com/shared/static@https://bbs.gpuworld.cn/mirror@g' CMakePreBuild.sh重新cmake编译

-

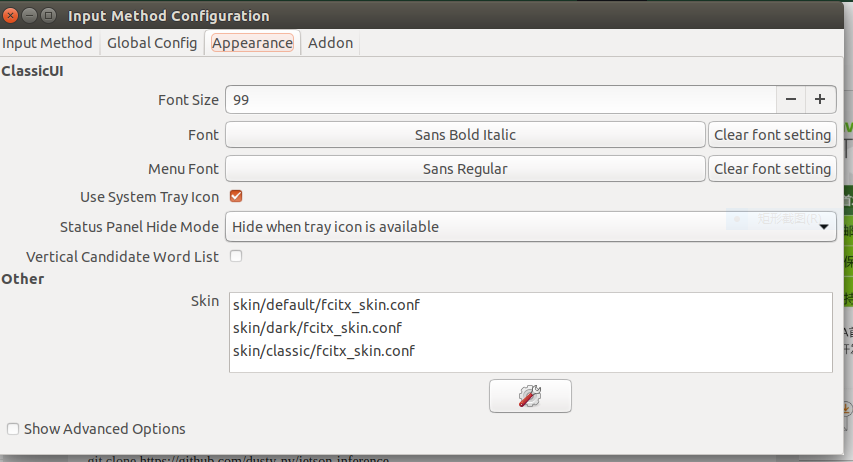

jetson nano fcitx中文输入法 没有提示框和提示框字体太小的解决办法posted in 技术交流

没有提示框,需要卸载一个包。

sudo apt remove fcitx-module-kimpanel提示框字体太小看不清,skin选择classic,同时调整字体大小

-

RE: 蓝鲸机器人采用的imu是razor_9dof_imu吗?posted in 技术交流

@terminal 不是,校准参考https://doc.bwbot.org/en/books-online/xq-manual/topic/113.html

-

测试amcl导航时机器人移动很慢,修改DWA参数也无效的解决办法posted in 技术交流

DWA局部规划器需要使用odom话题里面的twist信息,如果配置move_base时没有配置好odom话题,或者odom话题没有发布,则可能出现这种情况。解决办法是,将move_base中的odom话题remap成自己机器人的里程计话题。

-

RE: 采用V-SLAM技术,Intel发布RealSense T265深感模组posted in 行业动态

@xiaoqiang 这款产品的特点是V-SLAM直接跑在传感器内部的vpu里面了,不需要占用主机资源,而且支持闭环优化。它和xvisio诠视科技公司的产品几乎是一模一样的。由于内部VPU和intel的神经计算棒NCS2是一样的,它也可以支持tensorflow加速,因此这款传感器除了V-SLAM,后续在目标识别等领域也有极大的应用潜力。

-

采用V-SLAM技术,Intel发布RealSense T265深感模组posted in 行业动态

1月24日消息,Intel发布一款全新深度摄像头RealSense T265,可为AR/VR头显、机器人、无人机提供6DoF inside-out追踪。据悉,该产品采用Intel独有的V-SLAM技术,一项混合了视觉惯性测程(VIO)和SLAM的技术。

Intel RealSense部门副总裁兼总经理Sagi Ben Moshe表示:“T265的作用是补充现有的Intel RealSense深度摄像头,通过集成的V-SLAM技术为产品研发提供快速通道。”

T265使用Intel Movidius Myriad 2 VPU(视觉处理单元)来处理追踪数据,该VPU的好处在于可以让摄像头实现小巧、节能的设计。

这款新产品的定位是,一款面向企业和建造机器人和无人机的个人的解决方案,它的特点是能够在仓库和工业中心等地点,根据物理环境提供地点信息。这款新摄像头可让硬件厂商实现6DoF追踪的集成,将T265的追踪与RealSense D系列的深度传感功能结合效果更好。

T265目前售价199美元,https://click.intel.com/order-intel-realsense-tracking-camera-t265.html

-

RE: 谷歌cartographer使用速腾聚创3d激光雷达数据进行三维建图posted in 激光雷达

@Duke-Allen cartographer还没有正常工作,没有开始建图所以没有发布map相关的tf。先让 cartographer正常工作,开始建图后就有了

-

RE: 谷歌cartographer使用速腾聚创3d激光雷达转二维数据进行2d建图posted in 激光雷达

# cartographer_ros/configuration_files/xiaoqiang_rslidar_scan.lua文件里面设置是否使用imu、odom数据的参数是这两个: use_odometry = true #true使能里程计,false禁用里程计 TRAJECTORY_BUILDER_2D.use_imu_data = false #true使能IMU,false禁用IMU -

RE: 谷歌cartographer直接使用速腾聚创3d激光雷达三维数据进行2d建图posted in 激光雷达

@Jaccica 没有错误,新版map_server支持occ和free参数,不支持这些参数的老版本map_server保存出来的地图会有问题

-

RE: RVIZ可视化窗口中能给检测到目标添加一个立方体的框吗?posted in ROS教程

@道灼 试试发布成marker类型话题 http://wiki.ros.org/rviz/DisplayTypes/Marker

-

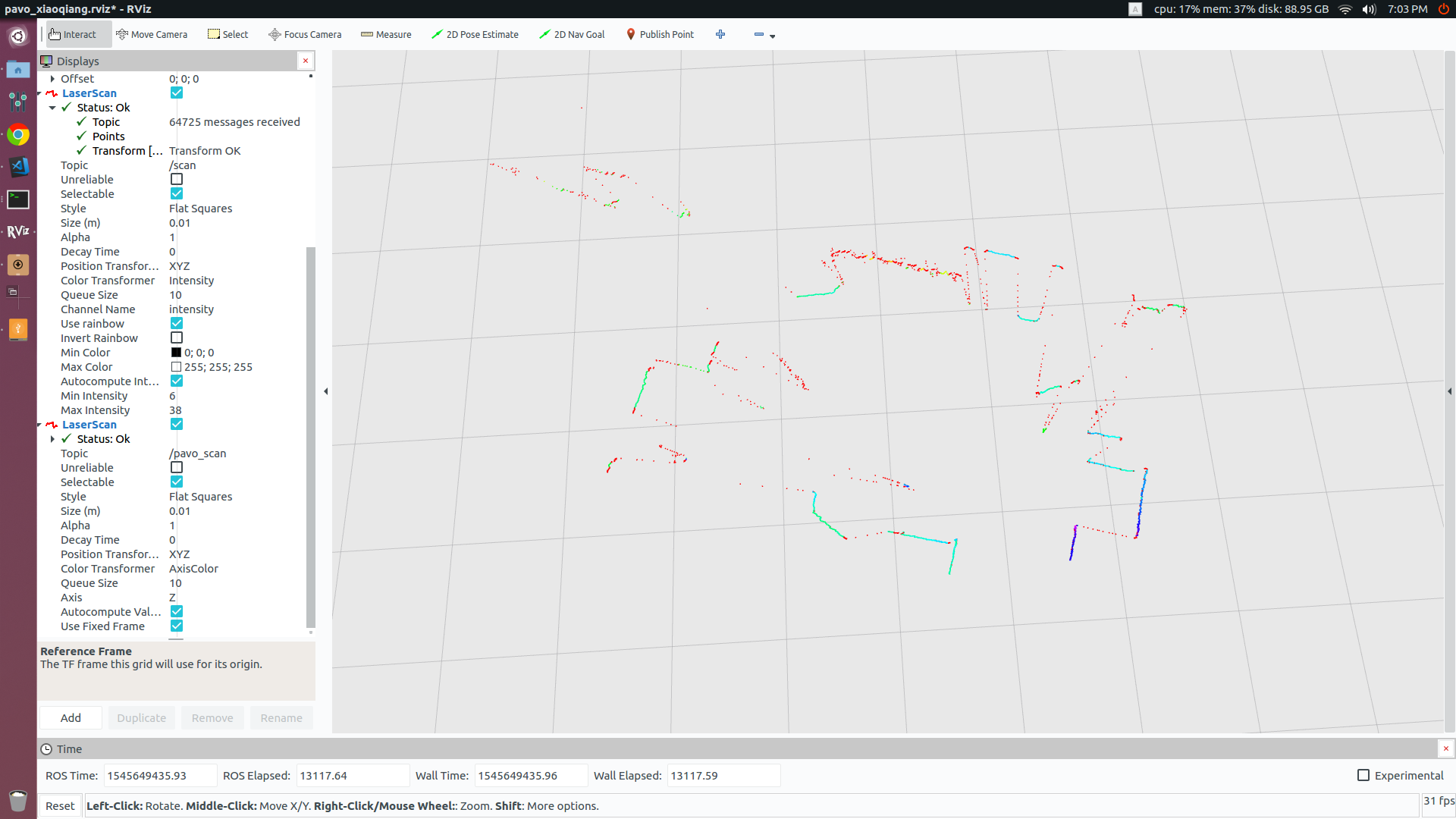

星秒科技tof激光雷达PAVO的ros驱动安装与测试posted in 技术交流

下载链接:PAVO激光雷达windows资料包

星秒科技激光雷达pavo的供电是直流12v 1A,通信接口是rs485网络接口。小强ros开发平台用户可以用底盘dc电源头供电,主机的网口也可以直接连接雷达。下面介绍它的ros驱动安装和测试教程,如果是和小强平台一起购买的雷达,小强主机出厂时已经配置好驱动,请直接跳过安装部分。

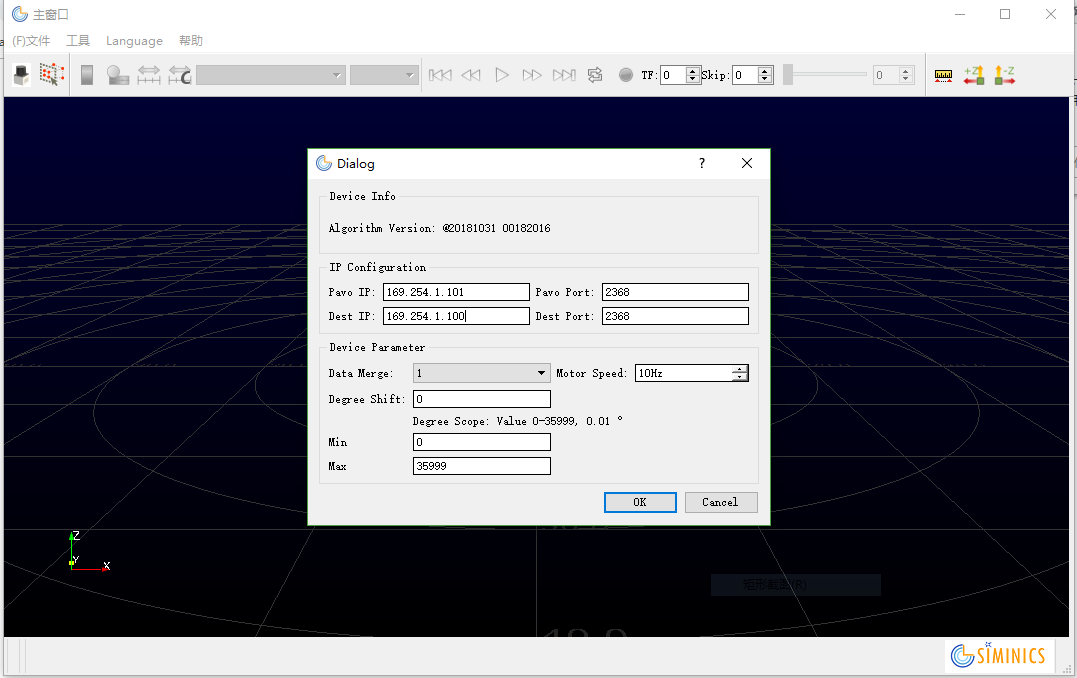

1.在windows平台设置雷达网络接口参数

pavo雷达的网络接口是静态ip分配方式,且需要用官方配置软件编辑它的固件才能设置网络参数。

使用官网提供的PavoView软件,根据《PavoView使用指南-V1.1.2.pdf》手册设置雷达和主机的ip地址。因为主机往往还需要连接其他网络,因此最好按照下图设置成169.254.x.x网段,这个网段ubuntu默认为本地网络,不会干扰其它网络的运行。

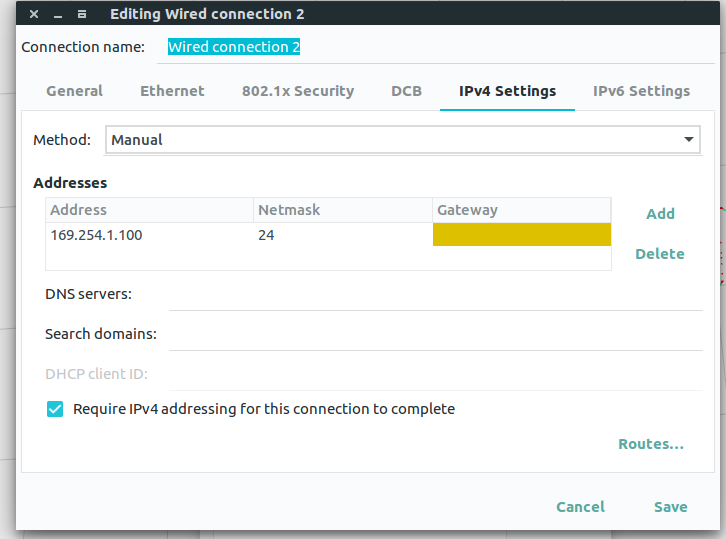

它的ros驱动也需要指定ip地址参数,为了后续教程的方便,请将ip地址按照上图的地址设成一模一样2.根据步骤1中的ip地址设置ros主机的有线网络

3.安装ros驱包pavo_ros

#ros_rslidar需要安装到ros工作空间,以小强主机为例 cd ~/Documents/ros/src git clone https://github.com/BluewhaleRobot/pavo_ros.git #tof雷达会有拖尾现象,需要用laser_filters包进行过滤 git clone https://github.com/BluewhaleRobot/laser_filters.git cd .. catkin_make4.将雷达接入电源,同时用网线连接ros主机,启动ros驱动launch文件

roslaunch pavo_ros xiaoqiang.launch #启动成功后,驱动节点默认会发布10hz的点云话题/scan,这个话题的frame_id是laser,上面的launch文件也发布了base_link到laser的tf关系,请根据实际安装参数进行调整。6.在rviz中显示发布的点云数据

roscd pavo_ros/rviz rviz -d pavo_xiaoqiang.rviz

在rviz里面可以对比原始数据/pavo_scan和过滤处理后的数据/scan的区别。 -

小觅双目摄像头固件升级失败的解决办法posted in 技术交流

小觅官方没有提供固件烧录工具,只提供了固件升级工具,但是他们方案实际是一种通用方案,找到了其它摄像头厂家的烧录工具,测试后发现可以正常烧写小觅摄像头。

固件升级失败后,摄像头会无法识别,在windows设备管理器未知设备选项里面会显示"WestBridge",解决办法是先安装摄像头的usb3.0控制器驱动,这样就可以用usb3.0控制器厂家提供的固件升级工具重新烧写固件。

详细步骤参考:http://withrobot.com/en/technical-data/?ckattempt=1&uid=20&mod=document&pageid=1 -

ubuntu upstart任务崩溃,错误提示:exception basic_string::_M_constructposted in 技术交流

碰到一个ros程序,正常命令行启动一切正常,但是upstart方式启动会触发异常。经过debug发现是因为使用了“std::getenv”方法,这个方法在upstart启动方式下显然是有问题的,因为此时很多环境变量是没有设置的,即导致获取失败引发后续bug。

-

小强ROS机器人教程(29)___安装使用zed相机cpu版本ros驱动posted in 产品服务

官方sdk和ros驱动需要使用cuda,如果主机不支持cuda就无法使用这些软件包,也就无法使用zed相机。很幸运,zed相机是一个uvc标准的摄像头,有第三方的ros驱动可以支持无nvidia显卡的主机使用。因为只使用cpu,因此只能获取摄像头的双目图像,官方的slam和深度信息处理功能是无法使用的。

下文将详细介绍如何在小强主机上安装使用zed相机cpu版本ros驱动。对于一些出厂已经配置过zed的小强用户,请跳过驱动安装步骤,可以直接启动相关launch文件进行测试。1. 在主机ros catkin工作空间中下载安装zed的ros驱动包

如果是已经配置好的小强用户,可以直接跳过本步骤。

#假设catkin工作空间在~/Documents/ros cd ~/Documents/ros cd src/ git clone https://github.com/BluewhaleRobot/zed_cpu_ros.git cd .. catkin_make2.将zed接入主机usb,添加udev规制,将设备号映射为/dev/video003

如果是已经配置好的小强用户,可以直接跳过本步骤。

#查看zed相机的id信息,即下条命令输出结果中以{SUBSYSTEM=="video4linux"}开头的部分内容,/videoXXX需要替换成实际设备号 udevadm info --name=/dev/videoXXX --attribute-walk#根据id信息,建立udev规则文件/etc/udev/rules.d/56-zed.rules,下面内容可供参考。对于非小强用户,xiaoqiang需要更换成自己的计算机用户名 SUBSYSTEM=="video4linux", ATTR{name}=="ZED: ZED", MODE:="0666", OWNER:="xiaoqiang", SYMLINK+="video003"#最后重新加载udev规则 udevadm control --reload-rules #重新插拔zed相机,如果 ls /dev可以看到video003设备,说明操作成功。3.启动ros驱动节点,正常的话可以在rviz中订阅显示zed的图像数据。

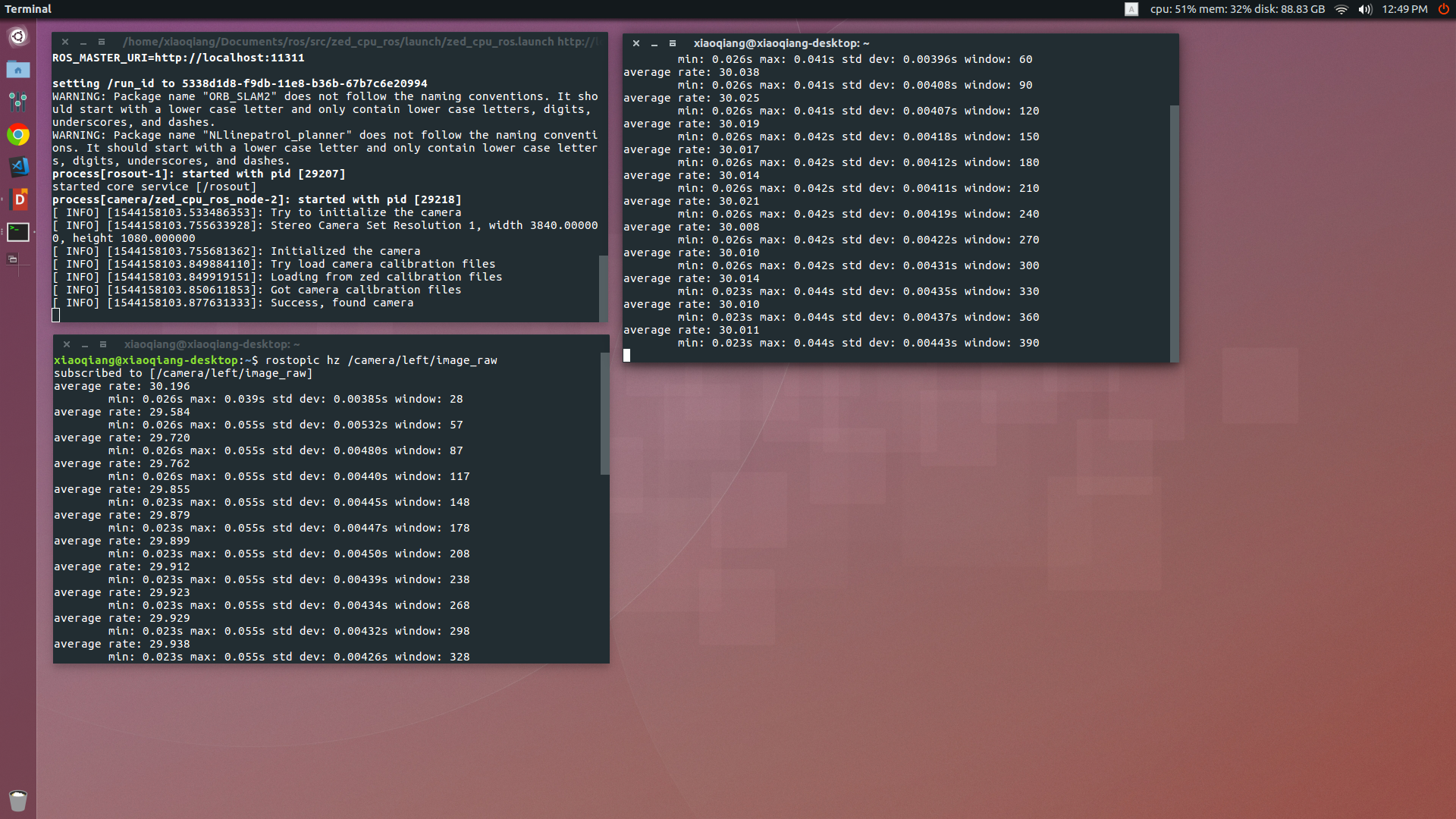

roslaunch zed_cpu_ros zed_cpu_ros.launch